Non è più una novità: l’intelligenza artificiale è destinata a diventare progressivamente sempre più importante per l’industria videoludica, come dimostrano le ultime tendenze del mercato.

È passata poco più di una settimana da quando Nvidia, il colosso americano ormai in cima alle classifiche mondiali per capitale, ha annunciato la nuova serie di GPU “Blackwell”, e non è un caso che l’evento abbia riacceso con vigore l’argomento di cui sopra.

In particolare, la tecnologia MFG (Multi-Frame Generation), destinata unicamente a questi nuovi modelli, sembra aver dato all’azienda la possibilità di fare affermazioni piuttosto audaci sulla supposta equivalenza fra una RTX 4090 e una RTX 5070 in termini di performance. La verità, tuttavia, è che manca un grosso asterisco, che meritava di essere esplorato.

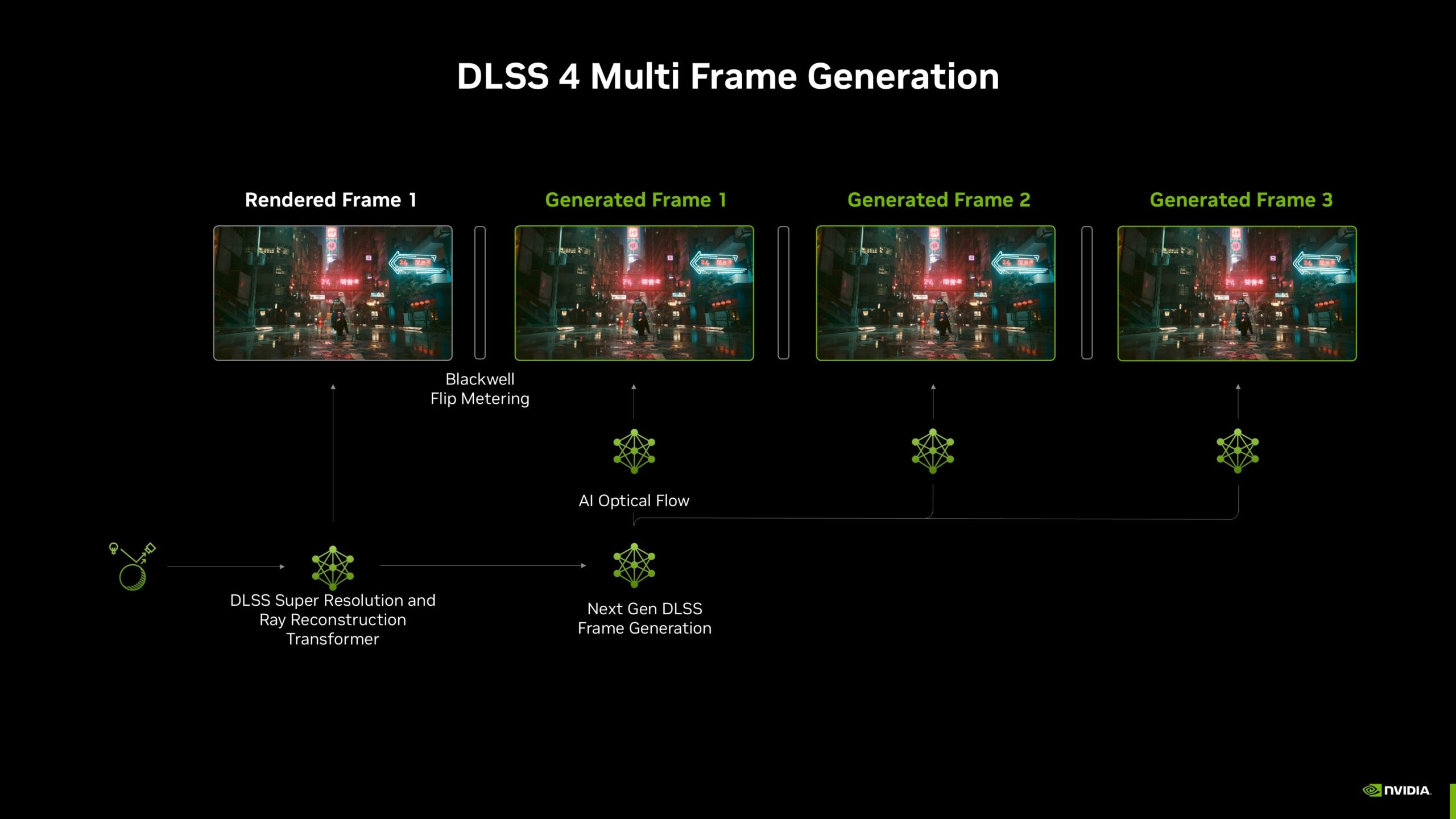

Questa nuova funzione, infatti, essendo una delle tante incentrate sull’intelligenza artificiale presentate durante il keynote, permette alla GPU di renderizzare fino a quattro frame artificiali per quadruplicare a tutti gli effetti il framerate. In sostanza, su 16 frame, la GPU ne deve renderizzare tradizionalmente soltanto uno. Parliamoci chiaro: si tratta di una tecnologia semplicemente clamorosa, una rivoluzione in grado di trasformare i 30 FPS di Cyberpunk 2077 con Path Tracing abilitato in ben 230-250 con un semplice clic. Ovviamente, esistono numerose possibili problematiche legate alla latenza, agli artefatti grafici e ai glitch dovuti all’intelligenza artificiale… ma nulla su cui Nvidia non stia attivamente e costantemente lavorando per trovare una soluzione.

Dietro un futuro radioso fatto di rivoluzioni tecniche e nuove improbabili sigle da assimilare, esiste però un muro di nebbia fitto e minaccioso che sembra avere profonde radici nella realtà della nostra industria preferita. AI, AI, AI… Non è certo una colpa perseguire l’intenzione concreta di semplificare la vita ai nostri computer, ma non si può fare a meno di pensare che la situazione sia ben più complessa di quella che ci viene mostrata.

Ed è in questo contesto che si sono sviluppate opinioni estremamente contrastanti, che noi vorremmo esaminare nella maniera più analitica e distante possibile, per permettervi di trovare una vostra personale posizione in merito.

Le critiche all’AI

La morte dell’ottimizzazione

Il tempo passa inesorabile e, con esso, si manifesta la necessità di trovare nuove esperienze e traguardi da considerare il prossimo passo logico verso il miglioramento della tecnologia. Nell’ormai lontano 2018, fu il ray tracing a essere presentato come la prima grande sfida, e da allora il gaming (quantomeno su PC) non fu più lo stesso.

Nonostante un inizio lento e sofferto (ndr: io ero fra i “pionieri” che acquistarono al lancio una RTX 2080), il ray tracing è stato effettivamente quel primo passo verso l’abbandono delle cosiddette “gimmick grafiche” da parte degli sviluppatori. Sostanzialmente, si è iniziata a considerare la possibilità che l’illuminazione, anziché essere progettata ad hoc per la migliore resa, potesse venire calcolata automaticamente in maniera realistica, a discapito delle performance, le quali venivano in qualche modo recuperate dalle tecnologie di scaling come il DLSS (Deep Learning Super Sampling).

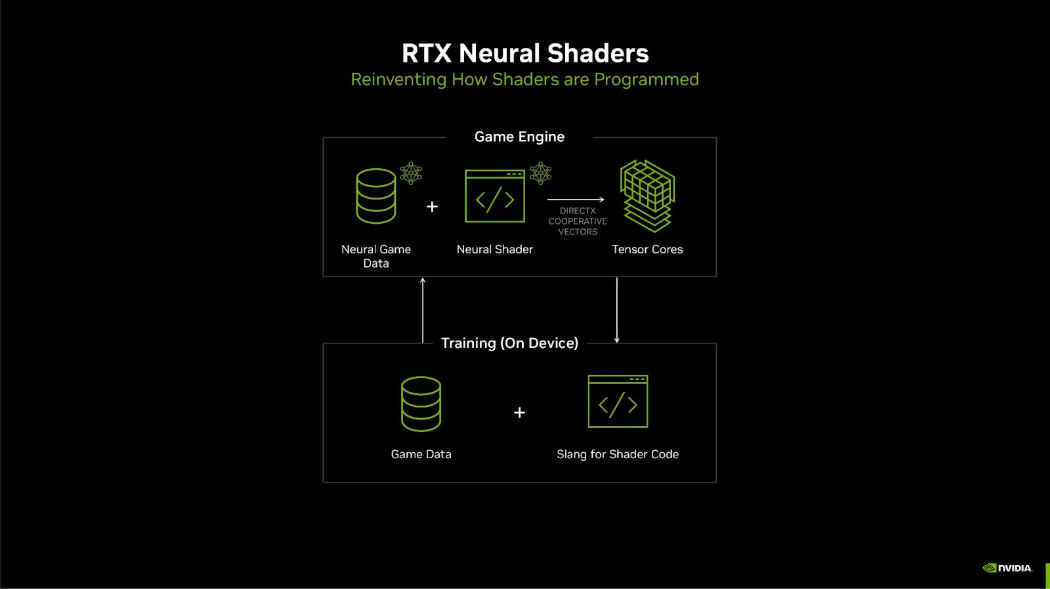

Il DLSS, per sua natura, è una magia tecnologica che sa di evidente compromesso, funzionando in modo che il titolo di turno venga renderizzato a una risoluzione molto inferiore, per poi essere upscalato dall’AI che ne analizza e rielabora i dettagli. In poche parole, FPS apparentemente gratuiti per qualsiasi gioco che supporti la tecnologia.

C’è chi considera questa la prima ragione dell’impigrimento degli sviluppatori nei confronti del lavoro di ottimizzazione, su cui viene posta una pezza disattenta tramite l’upscaling. Ancora peggio, la componente grafica dei videogiochi di ultima generazione non sembra aver compiuto quel passo impressionante che ci si aspettava. Ad oggi, titoli che facevano largo uso dei tradizionali “gimmick” fanno scalpore per il loro comparto grafico fuori dal tempo: basti pensare a Battlefield 1 o Batman: Arkham Knight quando confrontati ai recenti Star Wars Outlaws o Gotham Knights.

In un certo senso l’ottimizzazione era di per sé considerabile un’arte, il cui fondamento era la costante ricerca di opportunità per ottenere il massimo con il minimo dispendio di risorse.

La situazione sembra essere peggiorata ulteriormente di recente, con l’avvento dell’Unreal Engine 5 e l’introduzione del Lumen nelle pipeline di sviluppo come soluzione di software ray tracing generalmente più abbordabile ma comunque molto pesante e non priva di spigoli significativi. Per quanto si voglia essere positivi, è impossibile non notare come i titoli che fanno uso di questo motore escano quasi sempre in condizioni disastrose: fra stuttering, performance penose a prescindere dagli upscaler, crash e… bisogna dirlo, un look e un feeling sempre più generici e simili quando si rincorre il fotorealismo.

In sostanza, ci troviamo in un periodo in cui i videogiochi sembrano aver rallentato fino a fermarsi da un punto di vista evolutivo, sebbene i requisiti minimi e massimi continuino a lievitare vertiginosamente. Certo, non si può fare di tutta l’erba un fascio, ed esistono titoli che sfruttano al meglio queste nuove tecnologie per offrire uno specchio niente male su un nuovo standard che si fatica a raggiungere, ma sono pochi e difficilmente accessibili.

L’era del raster sembra dunque essersi conclusa, e l’industria appare inevitabilmente orientata verso una compressione artificiale del lavoro grafico che vede l’AI come protagonista indiscussa, con tutti i pregi e difetti del caso.

Quanto ha senso che siano esclusivamente le schede video di ultima generazione a godere di queste funzioni? E quanto invece sarebbe necessario considerare l’AI come un aiuto e un compromesso necessario per le GPU destinate alle fasce più basse del mercato? Ma soprattutto, non sarebbe auspicabile un mercato in cui le GPU più potenti (ed estremamente costose) siano in grado di girare i titoli in 4K con RT ad almeno 60 FPS senza compromessi artificiali?

L’ascesa delle nuove tecnologie

L’altra faccia della medaglia

Parallelamente a queste accuse, esiste una grossa fetta di giocatori, generalmente composta da appassionati ed esperti di tecnologia, che riconoscono il verificarsi di questi fenomeni ma riescono a trovarvi una giustificazione concreta.

Si tratta di una visione progressista, che vede il progressivo aumento dei requisiti come un sacrificio necessario verso lo sviluppo di una nuova era per i videogiochi. Come nel 2007 Crysis friggeva le schede video più potenti, portando in moto un mondo dal dettaglio mai visto prima, il rendering dei giochi dettato secondo le medesime regole della nostra realtà sembra il prossimo grande traguardo da raggiungere a ogni costo. Secondo questo ragionamento, l’aumento estremo dei requisiti in termini di VRAM (già all’uscita si discuteva di come 10GB fossero insufficienti per una RTX 3080), così come la necessità di integrare i tensor core o equivalenti nella propria configurazione non sono che un risultato delle intenzioni dell’industria di forzare l’avanzata verso nuovi orizzonti tecnologici.

Non solo, l’automatizzazione di funzioni come Lumen o Nanite nei processi di sviluppo consente agli sviluppatori di concentrarsi maggiormente su altri aspetti del videogioco, permettendo anche ai team meno esperti e con budget limitati di raggiungere risultati altrimenti impensabili. Del resto, l’Unreal Engine 5 è uno strumento versatile e ricco di opportunità, e non è affatto detto che debba essere utilizzato esclusivamente per ottenere un’estetica fotorealistica.

Insomma, è necessario fare dei sacrifici in nome del progresso, ed è imperativo entrare nell’ottica che l’intelligenza artificiale, con i suoi frame “finti” e l’upscaling, sia il nuovo standard da utilizzare in maniera obbligatoria per ottenere il meglio, a prescindere dal proprio investimento. Del resto, come nel 2018 si introduceva il ray tracing nei videogiochi, ci troviamo adesso in procinto di inseguire il sogno del path tracing, un’implementazione sicuramente più precisa ma anche infinitamente più pesante e dispendiosa di una tecnologia che solo ora sta vedendo la più larga diffusione.

E voi cosa ne pensate? Vedete l’AI come l’ennesima scorciatoia verso un prodotto sempre meno artigianale, o riconoscete il suo ruolo imprescindibile nel superamento degli attuali limiti tecnici?

Seguiteci sul nostro sito per altre recensioni e articoli in arrivo nei prossimi giorni.